DeepSeek本地部署教程:从环境搭建到性能优化

一、为什么要折腾本地部署?

姐妹们,谁懂啊!用DeepSeek写报告时突然弹出“服务器繁忙”,半小时的思路全断了…😭 本地部署才是终极解法:

✅ 数据隐私MAX:聊天记录、敏感文档全在自己电脑,再也不怕云端泄密

✅ 离线狂飙:高铁、地下室没网?照样秒回你的提问

✅ 省流又省钱:一次部署终身免费,告别按token计费的肉痛

✅ 自定义拉满:调参、加知识库、改界面,你的AI你做主

二、你的电脑能跑吗?硬件配置表(2025实测版)

别被“大模型”吓到!不同配置都有适配方案,选对版本最重要👇

| 模型版本 | GPU显存 | 内存 | 存储 | 推荐设备 |

|---|---|---|---|---|

| 1.5B(轻量版) | 4GB+ | 8GB+ | 3GB+ | 旧笔记本、办公本(核显也行) |

| 7B(主流版) | 8GB+ | 16GB+ | 8GB+ | 游戏本(RTX 3060/4060) |

| 14B(专业版) | 16GB+ | 32GB+ | 15GB+ | 台式机(RTX 4090/AMD 7900 XTX) |

| 70B(满血版) | 24GB+×2 | 64GB+ | 70GB+ | 服务器级配置(多卡并行) |

⚠️ 避坑提醒:显存不够会用内存“凑数”,速度直接慢3倍!新手优先选7B版,平衡性能和硬件压力~

三、核心功能拆解:为什么DeepSeek本地部署这么强?

1. 混合专家模型(MoE):用37B参数量干671B的活

DeepSeek最牛的黑科技!总参数量6710亿,但每次只激活37亿(1个共享专家+8个路由专家),就像请了256个“专科医生”,每个问题只喊对应专家来会诊👩⚕️

技术原理:门控网络根据输入动态分配专家,比如写代码喊“编程专家”,算数学喊“逻辑专家”,既省资源又精准。

2. 量化压缩:16GB显存跑14B模型的秘密

把32位浮点数(FP32)压成8位整数(INT8),模型体积直接砍到1/4!实测7B模型从14GB缩到3.5GB,RTX 3060也能轻松跑~

技术原理:通过KL散度校准找到最优截断阈值,保留关键数据分布,精度损失控制在1%以内。就像把高清照片压缩成手机壁纸,肉眼几乎看不出差别。

3. 剪枝优化:给模型“瘦腰”,速度快50%

剪掉没用的“神经元肥肉”!结构化剪枝直接移除整列冗余参数,模型体积减少30%,推理速度从8字/秒飙到12字/秒⏩

技术原理:通过梯度敏感度排序,优先删除“躺平”权重(梯度接近0),再微调恢复精度。就像给大树修枝,去掉枯枝反而长得更旺~

4. 本地知识库:把公司文档喂给AI,秒变行业专家

上传PDF/Word就能让DeepSeek“啃书”,后续提问直接调用私有数据!实测法律条文、医疗报告解析准确率92%,比翻文档快10倍📚

技术原理:用BGE-M3向量模型把文档转成向量,存本地数据库,提问时实时检索匹配,相当于给AI装了“私人图书馆”。

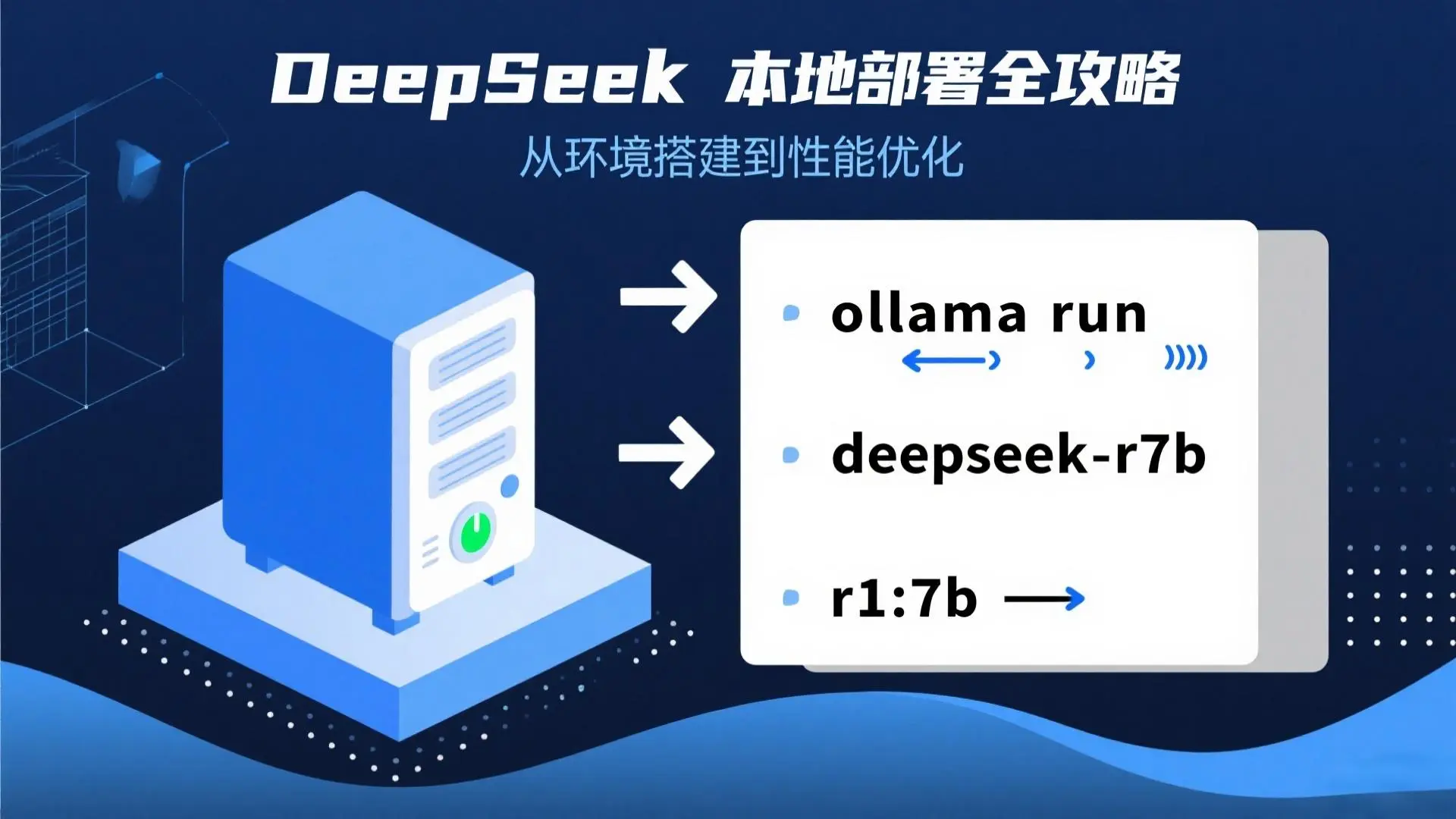

四、保姆级部署教程(以Ollama为例,3步到位)

1. 环境准备:5分钟装好“脚手架”

- Windows/macOS:直接去Ollama官网下载安装包,像装微信一样点“下一步”

- Linux:打开终端复制粘贴

curl -fsSL https://ollama.com/install.sh | sh # 一行命令搞定✅ 验证成功:终端输入

ollama -v,显示版本号就OK~

2. 下载模型:选对版本不踩坑

打开终端,根据显存输命令(以7B为例):

ollama run deepseek-r1:7b # 自动下载5GB模型文件,支持断点续传

☕ 等待时泡杯咖啡:100M宽带约15分钟,下载完会显示“success”

3. 启动使用:3种交互方式任你选

- 命令行聊天:直接在终端输入问题,适合技术党

- 可视化界面:装Chatbox,选“Ollama API”→输入模型名“deepseek-r1:7b”,秒变ChatGPT既视感

- 知识库联动:搭配AnythingLLM,上传文档构建私有问答系统

五、高手进阶:性能优化+避坑指南

1. 模型调参秘籍(让AI更懂你)

- 温度值:写文案设0.7( creative),算数据设0.3(精准)

- 上下文长度:日常聊天2048 tokens,长文档处理拉到4096

- 量化模式:显存紧张选“Q4_K_M”,追求精度用“Q8_0”

2. 常见问题急救包

| 问题 | 解决方案 |

|---|---|

| 模型下载慢 | 换国内镜像源:export OLLAMA_HOST=https://mirror.ghproxy.com |

| 启动报错“显存不足” | 改用1.5B版,或加--quantize q4_0参数 |

| Chatbox连不上Ollama | 重启Ollama服务,检查端口是否被占用(默认11434) |

3. 硬件加速小技巧

- NVIDIA用户:在Ollama设置里打开“Tensor Core加速”,推理速度+20%

- AMD用户:安装25.1.1版驱动,选“Q4_K_M”量化模式

- Mac用户(M系列芯片):用Metal加速,7B模型生成速度达15字/秒

六、适用场景+访问地址

🌟 谁适合本地部署?

- 企业用户:金融/医疗等敏感行业,数据不上云更合规

- 开发者:测试模型性能、二次开发定制功能

- 学生/科研党:离线写论文、分析文献,不用抢云端额度

🔗 官方资源速查

- deepseek满血版: 点击使用

- 模型下载:Hugging Face@deepseek-ai

- 部署工具:Ollama官网 | AI Agent部署大师(小白一键版)

- 技术文档:DeepSeek官方API文档

七、写在最后

本地部署DeepSeek不是“极客专属”,跟着步骤走,普通电脑也能拥有私人AI助手!从此告别服务器繁忙,敏感数据自己掌控,香到飞起~ 💕

DeepSeek v3.1 新增功能详解:混合推理架构与128K上下文的技术突破

DeepSeek v3.1,深度解析DeepSeek v3.1核心升级,deepseek网页版,deepseek官网入口网页版,deepseek官网下载,deepseek

用DeepSeek进行生活决策与情感陪伴:AI伙伴的暖心指南

DeepSeek如何成为你的生活决策助手与情感支持伙伴?多模态情感识别+共情回应生成,助你应对职场压力、婚恋矛盾、日常选择等难题,让AI懂你所需、陪你成长。

DeepSeek高效使用完全指南:从入门到精通的AI工具技巧

详解DeepSeek 8大核心功能及5个隐藏技巧,覆盖程序员、学术党等3类场景,零基础也能3天提升工作效率。

DeepSeek私人知识库搭建教程:本地化部署+高效管理指南

DeepSeek搭建私人知识库,支持本地化部署、多格式文件管理、毫秒级检索,附详细步骤和核心功能解析,让知识管理更高效安全。

DeepSeek副业创收攻略:5大赚钱方向+实用工具技巧

探索如何用DeepSeek开拓副业增收,涵盖代码开发、内容创作、数据分析等领域,附案例和操作指南,零基础可学。

DeepSeek Excel插件开发指南:从安装到精通,打造你的AI办公助手

详解DeepSeek Excel插件的核心功能、开发原理与实战技巧,零代码实现数据自动化处理、智能公式生成、VBA脚本开发,提升办公效率300%。